El Internet de 2025 se parece menos a una autopista llena de coches conducidos por personas y más a una red logística donde circulan, a gran velocidad, humanos, aplicaciones, APIs y una legión de bots —incluidos los de Inteligencia Artificial— compitiendo por contenido, ancho de banda y atención. Esa es, en esencia, la fotografía que traza el “Resumen del año 2025” de Cloudflare Radar: un ejercicio de observación a gran escala que ayuda a entender cómo está cambiando la red desde dentro.

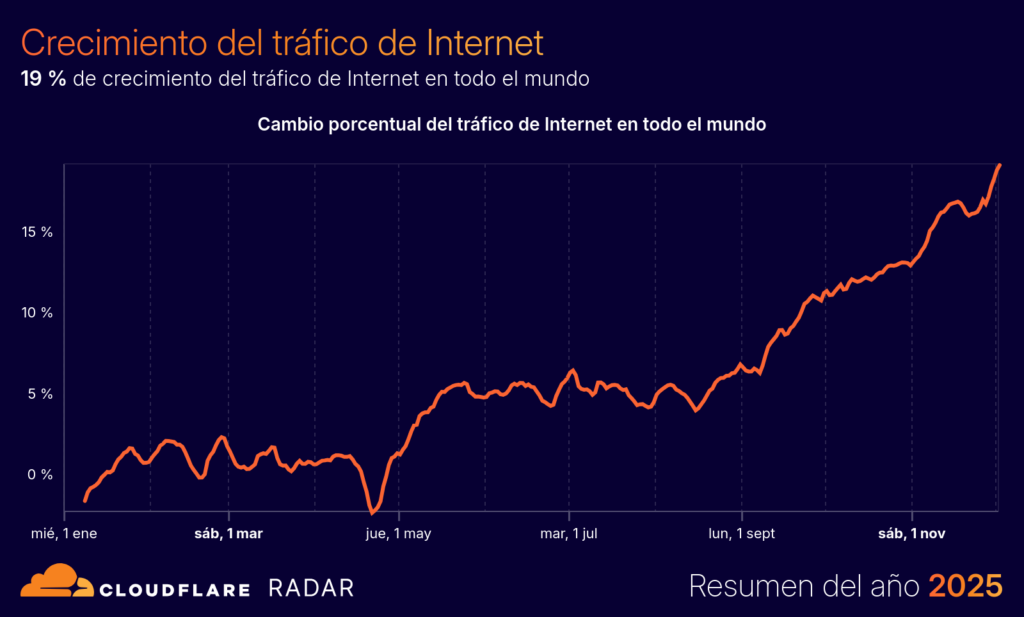

El primer dato que sirve de contexto es el crecimiento: el tráfico global de Internet aumentó un 19 % durante 2025, un salto que refuerza la idea de que la conectividad ya no es un complemento, sino infraestructura crítica para trabajo, ocio, comercio y servicios. Pero lo más relevante no es solo cuánto crece, sino quién genera ese tráfico y con qué objetivo.

El auge de los bots de IA ya es visible en el tráfico web “real”

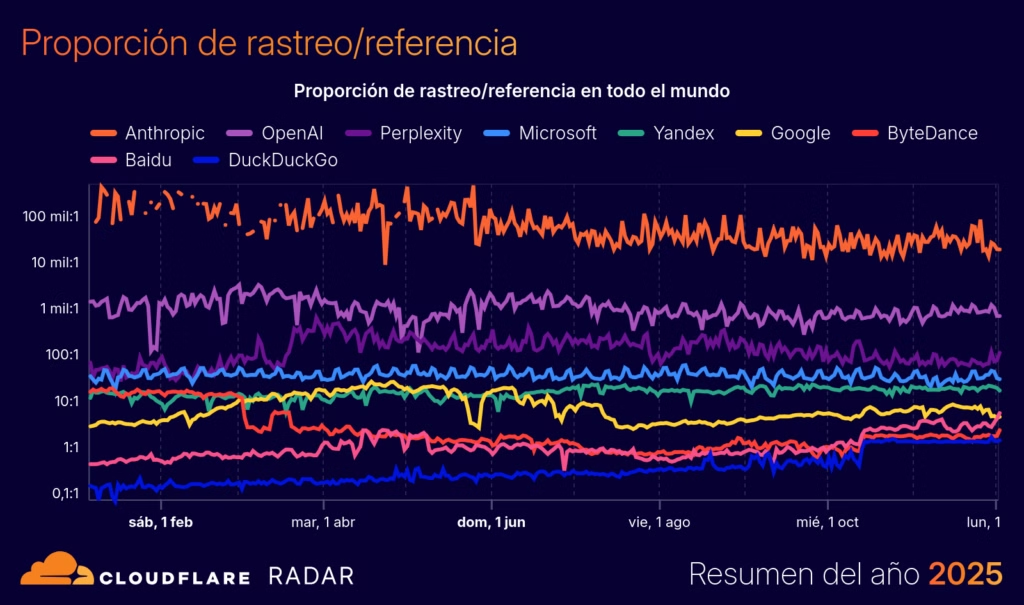

Uno de los puntos más reveladores del informe es que los bots de IA —rastreadores asociados al entrenamiento, búsqueda y acciones de usuario— ya representan una parte medible de las solicitudes HTML. En el reparto anual que recoge Radar, el tráfico humano supone el 43,5 %, mientras que los bots no relacionados con IA alcanzan el 47,9 %. En medio de ese reparto aparecen dos piezas que marcan tendencia: Googlebot (4,5 %) y los bots de IA (4,2 %).

Para medios digitales, ecommerce y creadores de contenido, este matiz importa más de lo que parece: una fracción creciente de la carga que soportan servidores, CDNs y WAFs no viene de lectores, sino de agentes automatizados que “consumen” páginas para indexar, resumir o alimentar modelos. Y eso abre un debate incómodo: ¿quién paga esa factura de infraestructura cuando el valor económico se genera fuera del sitio?

A nivel técnico, el informe también muestra que “Formación” (entrenamiento) es el propósito de rastreo más activo dentro del tráfico de bots de IA, por delante de búsqueda o acciones de usuario. Traducido: la web sigue siendo cantera.

HTTP/3, APIs y clientes automatizados: el Internet que pisan los desarrolladores

El Radar 2025 también deja claro que el usuario final es solo una parte del tablero. El tráfico vinculado a APIs continúa creciendo y buena parte de ese volumen es automatizado. En ese mundo, el “cliente” no siempre es un navegador, y el ranking de lenguajes más usados para clientes de API automatizados lo refleja: Go lidera con un 20 %, seguido de Python (17 %), Java (11 %), Node.js (8,3 %) y .NET (2,3 %).

Esto es una pista directa para equipos de desarrollo y plataforma: optimizar APIs hoy no es solo latencia y throughput, también es compatibilidad y ergonomía con los ecosistemas que más golpean tus endpoints. Si tu servicio se integra con otros, probablemente lo haga desde Go o Python.

En paralelo, el cambio de protocolo ya no es una promesa: HTTP/3 representa el 21 % del tráfico global observado (con HTTP/2 en el 50 % y HTTP/1.x en el 29 %). Para desarrolladores web, esto pone sobre la mesa decisiones prácticas: QUIC y HTTP/3 pueden mejorar tiempos de conexión y tolerancia a pérdida de paquetes, pero también exigen revisar observabilidad, mitigaciones antiabuso y compatibilidad en redes corporativas.

La criptografía poscuántica deja de ser teoría y entra en el tráfico TLS

Otro dato que llama la atención, por su carga estratégica, es la adopción de cifrado poscuántico: el 52 % del tráfico TLS 1.3 utiliza técnicas de encriptación poscuántica según Radar, impulsado por compatibilidad creciente en navegadores y activación por defecto en redes como la de Cloudflare.

Para el gran público, esto suena lejano. Para responsables de seguridad y arquitectura, es una señal: el “recopilar ahora, desencriptar más tarde” ya es un argumento operativo, no solo académico. Y cuando la base instalada empieza a moverse, las empresas que dependen de confidencialidad a largo plazo (sanidad, legal, I+D, administración pública) toman nota.

Rankings que explican cultura digital: quién manda y qué sube

El resumen anual también sirve para ver qué servicios dominan el “espíritu del momento” en Internet. En el Top 10 global aparecen, en este orden: Google, Facebook, Apple, Microsoft, Instagram, AWS, YouTube, TikTok, Amazon y WhatsApp.

En social, Radar apunta a un cambio simbólico: tras Facebook, Instagram y TikTok, Snapchat supera a X. Y en el metaverso, Roblox se mantiene como referencia.

La parte más interesante para quienes siguen la carrera de la IA generativa es que el informe constata el ascenso de rivales claros de ChatGPT: Claude, Perplexity y Gemini ya aparecen como competidores principales en popularidad/uso dentro del ecosistema de servicios. No es una predicción: es una señal de tracción sostenida.

Seguridad: mitigación al alza y una red más “hostil” para el despiste

En el plano defensivo, Radar cifra en un 6,2 % el tráfico global mitigado durante 2025, y atribuye un 3,3 % a mitigación de DDoS o reglas administradas de WAF. Es un recordatorio de que, para muchas organizaciones, la “normalidad” de la web ya incluye una capa constante de filtrado y contención.

También se contabilizan 174 interrupciones importantes de Internet observadas a nivel mundial, con causas que van desde cortes de energía y cable hasta ciberataques, condiciones meteorológicas o bloqueos gubernamentales. En otras palabras: la resiliencia deja de ser una palabra bonita cuando el mapa del año incluye cortes recurrentes.

Qué deberían sacar en claro empresas, desarrolladores y creadores

El “Resumen del año 2025” no es solo una lista de porcentajes: es una guía de prioridades.

- Para equipos de producto y negocio: la web se está llenando de intermediarios automatizados (bots de IA, agregadores, previews). Medir tráfico ya no equivale a medir audiencia.

- Para desarrollo: HTTP/3, el peso de las APIs automatizadas y los cambios en clientes dominantes (Go y Python) deberían influir en rendimiento, rate limiting y diseño de SDKs.

- Para seguridad y sistemas: más mitigación, más automatización, y un entorno donde la criptografía poscuántica empieza a formar parte del “por defecto”.

- Para creadores y medios: el coste del rastreo de IA deja de ser marginal; controlar qué se indexa, cómo y con qué condiciones se convierte en una decisión estratégica.

Preguntas frecuentes

¿Cómo afecta el crecimiento de bots de IA al rendimiento de un sitio web?

Puede aumentar consumo de CPU, ancho de banda y llamadas a base de datos, además de alterar analítica y métricas de conversión si no se filtra correctamente el tráfico automatizado.

¿Qué implica que HTTP/3 alcance una cuota relevante de tráfico?

Que optimizar solo para HTTP/2 ya no basta: conviene revisar compatibilidad de CDN, balanceadores, observabilidad y políticas antiabuso para tráfico basado en QUIC.

¿Cómo pueden los administradores limitar el rastreo no deseado sin romper SEO?

Combinando robots.txt (bien afinado), reglas de WAF/bot management, rate limiting, y segmentación por agentes verificados, manteniendo permisos claros para rastreadores de búsqueda legítimos.

¿Por qué es importante la adopción de cifrado poscuántico si aún no hay “ordenadores cuánticos” capaces de romperlo todo?

Porque el riesgo “captura hoy, descifra mañana” afecta a datos con valor a largo plazo. Si una organización maneja información sensible que debe seguir protegida durante años, el calendario de adopción se adelanta.