xAI ha dado un golpe de efecto en el competitivo mundo de los modelos de lenguaje con el lanzamiento de Grok 4 Fast, una evolución optimizada de la serie Grok 4. El nuevo modelo destaca no solo por su rendimiento en benchmarks, sino por su ventana de contexto de 2 millones de tokens, una capacidad que permite procesar libros enteros —como Moby Dick con sus 422 páginas— en una sola pasada y resumirlos con una rapidez inédita.

Un modelo pensado para velocidad y eficiencia

Grok 4 Fast se diseñó con un enfoque claro: máxima densidad de inteligencia al menor coste posible. Según xAI, el modelo logra rendimientos comparables a Grok 4 en benchmarks de razonamiento, pero usando un 40 % menos de “thinking tokens”, lo que se traduce en un ahorro de hasta 98 % en coste por tarea en comparación con modelos de frontera de su categoría.

En pruebas como AIME 2025 y HMMT 2025, Grok 4 Fast iguala o incluso supera a Grok 4 y compite con GPT-5 en precisión, pero con menor consumo de recursos.

La ventana de contexto de 2M tokens: un cambio de juego

Uno de los puntos más llamativos es su context window de 2 millones de tokens. Esto significa:

- Cargar obras completas: desde novelas clásicas hasta manuales técnicos extensos.

- Analizar bases documentales internas sin dividir en trozos.

- Resumir, comparar y razonar sobre documentos largos sin perder coherencia.

La demostración más emblemática fue ver cómo el modelo “devoraba” Moby Dick entero y lo resumía en cuestión de segundos, mostrando tanto velocidad como capacidad de mantener hilos narrativos complejos.

En un ecosistema donde OpenAI, Anthropic y Google suelen ofrecer contextos de entre 200k y 1M tokens en sus modelos premium, los 2M de Grok 4 Fast lo colocan en la élite de la memoria a largo plazo.

Benchmarks y densidad de inteligencia

Algunos resultados destacados de Grok 4 Fast en pruebas sin herramientas:

- GPQA Diamond: 85,7 % (muy cerca del 87,5 % de Grok 4).

- AIME 2025: 92 % (supera a Grok 4 y a Grok 3 Mini).

- HMMT 2025: 93,3 % (empatado con GPT-5 High).

- LiveCodeBench: 80 %, también cercano a modelos más grandes.

Lo interesante no es solo el resultado, sino el costo para alcanzarlo: con 40 % menos tokens, Grok 4 Fast maximiza la “densidad de inteligencia” por dólar invertido.

Capacidades de búsqueda y navegación

Grok 4 Fast fue entrenado con refuerzo para uso de herramientas, lo que le permite decidir cuándo ejecutar código o navegar por la web en tiempo real.

En benchmarks internos y de terceros, demostró ser especialmente potente en agentic search:

- BrowseComp (zh): 51,2 % (superando a Grok 4 y a modelos de OpenAI).

- X Bench Deepsearch (zh): 74 %, sobresaliendo en búsquedas complejas en la red social X.

- X Browse (evaluación interna): 58 %, con ventaja clara sobre modelos previos.

Esto lo convierte en un modelo idóneo no solo para tareas de razonamiento estático, sino también para contextos donde es necesario acceder y sintetizar información dinámica.

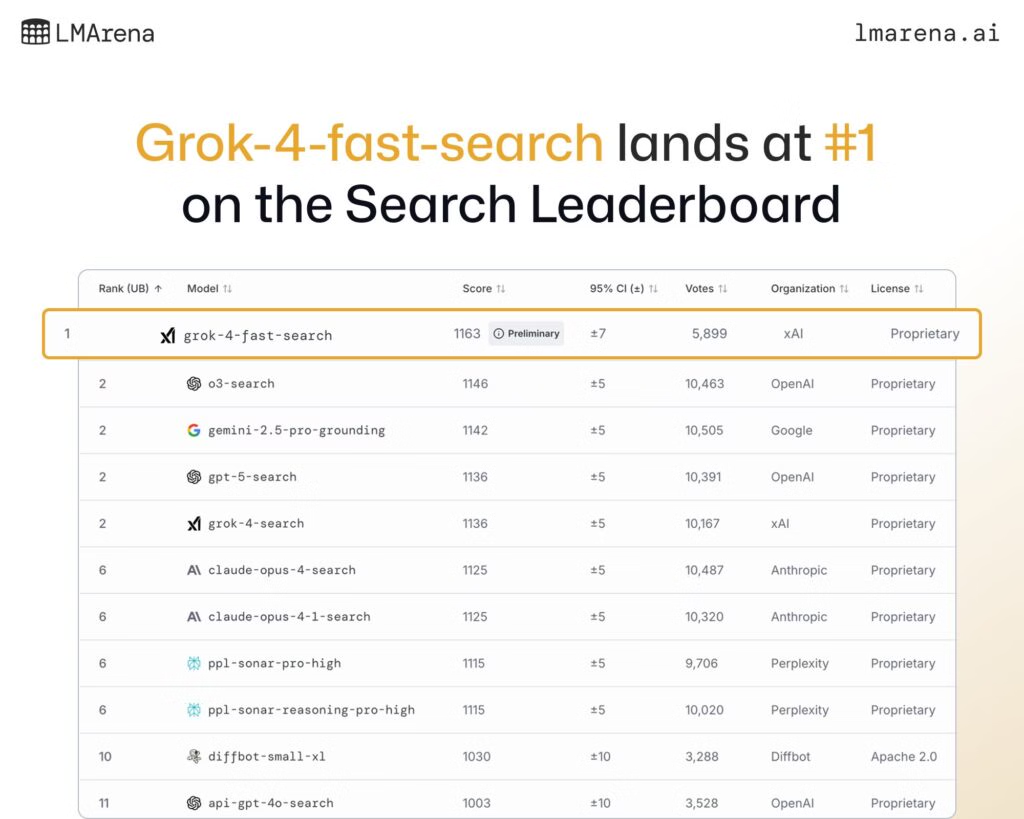

Resultados en LMArena

En el benchmark comunitario LMArena, Grok 4 Fast ha conseguido:

- #1 en Search Arena (bajo el nombre en clave menlo) con un Elo de 1163, superando a o3-search de OpenAI y a gemini-2.5-pro-grounding de Google.

- #8 en Text Arena (código tahoe), un resultado notable en un ranking donde los modelos de menor tamaño rara vez entran en el Top 10.

Arquitectura unificada: razonamiento y respuestas rápidas

Hasta ahora, algunos modelos diferenciaban entre “modo reasoning” y “modo directo”. Grok 4 Fast rompe esa división con una arquitectura unificada:

- Para consultas sencillas, responde de forma inmediata.

- Para problemas complejos, despliega cadenas de razonamiento largas.

- Todo con el mismo modelo y pesos, lo que reduce latencia y coste total.

Esto lo convierte en una opción viable para aplicaciones en tiempo real, como asistentes conversacionales, soporte empresarial y herramientas de búsqueda inteligentes.

Acceso y precios

xAI ofrece Grok 4 Fast en dos variantes:

- grok-4-fast-reasoning

- grok-4-fast-non-reasoning

Ambas con ventana de contexto de 2M tokens, accesibles vía la xAI API, OpenRouter y Vercel AI Gateway.

Los precios anunciados:

- Tokens de entrada (<128k): $0,20 / 1M.

- Tokens de salida (<128k): $0,50 / 1M.

- Tokens de entrada ≥128k: $0,40 / 1M.

- Tokens de salida ≥128k: $1,00 / 1M.

- Tokens cacheados: $0,05 / 1M.

Un esquema competitivo frente a modelos premium de OpenAI y Anthropic, sobre todo considerando la ventana de contexto extendida.

Conclusión

Grok 4 Fast se posiciona como un modelo rápido, rentable y con memoria de 2 millones de tokens, capaz de competir en benchmarks con gigantes como GPT-5 o Claude Opus, pero con un coste mucho menor.

Con su rendimiento en búsqueda (#1 en LMArena), su arquitectura unificada y la demostración de procesar Moby Dick completo en segundos, Grok 4 Fast apunta a ser un referente para empresas y desarrolladores que buscan escalabilidad y velocidad sin sacrificar calidad.

Preguntas frecuentes (FAQ)

¿Qué significa una ventana de contexto de 2M tokens?

Que el modelo puede analizar hasta 2 millones de tokens en una sola entrada, equivalente a miles de páginas de texto, sin necesidad de dividir documentos.

¿En qué se diferencia Grok 4 Fast de Grok 4?

Ofrece un rendimiento muy similar en benchmarks, pero con 40 % menos tokens de razonamiento y un coste hasta 98 % inferior.

¿Dónde se puede usar Grok 4 Fast?

Está disponible en la xAI API, OpenRouter y Vercel AI Gateway, y puede integrarse en aplicaciones empresariales y de consumo.

¿Qué casos de uso destacan con Grok 4 Fast?

- Análisis documental masivo (bases de conocimiento, manuales, libros).

- Búsqueda avanzada en tiempo real (web y X).

- Asistentes empresariales que requieren razonamiento eficiente y bajo coste.

vía: xAI news