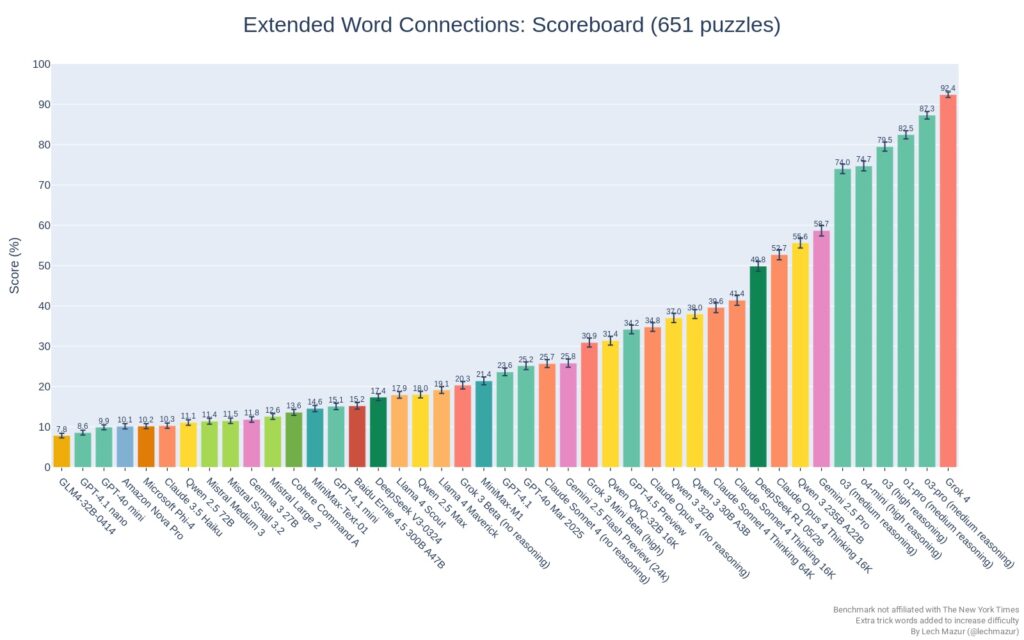

El modelo de lenguaje Grok 4 ha alcanzado el primer puesto en el exigente benchmark NYT Connections Extended, una prueba que evalúa la capacidad de razonamiento de los modelos de inteligencia artificial con 651 rompecabezas del popular juego de lógica del New York Times. Con una puntuación del 92,4 %, Grok 4 se posiciona por encima del resto de grandes modelos del mercado y supera incluso la media de aciertos de los jugadores humanos.

La clasificación, publicada por el desarrollador independiente Lech Mazur en el repositorio público nyt-connections, incluye decenas de modelos de última generación como GPT-4o, Gemini, Claude, Qwen, DeepSeek o LLaMA, en versiones optimizadas para tareas de razonamiento.

¿Qué es NYT Connections y por qué es relevante para evaluar la IA?

NYT Connections es un juego de lógica publicado a diario por el New York Times, en el que el jugador debe identificar cuatro grupos de palabras relacionadas dentro de una cuadrícula de 16 términos. El benchmark desarrollado por Mazur extiende el desafío al incluir hasta cuatro palabras trampa adicionales en cada puzzle, lo que incrementa significativamente la dificultad.

Según el propio autor, esta versión extendida evita la saturación de resultados observada en benchmarks anteriores y permite distinguir con mayor precisión las capacidades reales de razonamiento de cada modelo.

Grok 4, el nuevo referente

El modelo Grok 4, desarrollado por xAI —la empresa de inteligencia artificial impulsada por Elon Musk—, encabeza el ranking con un rendimiento del 92,4 % en los 651 rompecabezas. Le siguen o3-pro (87,3 %) y o1-pro (82,5 %), ambos modelos avanzados de la familia «o», también especializada en razonamiento multietapa.

En contraste, modelos ampliamente conocidos como GPT-4o (OpenAI), Gemini 2.5 Pro (Google) o Claude Opus (Anthropic) quedan bastante por debajo. GPT-4o, por ejemplo, registra una puntuación de apenas el 25,2 %, muy por debajo de lo esperado para un modelo de uso general.

IA vs humanos: un duelo desigual

El benchmark incluye una comparación directa con los datos de rendimiento de usuarios humanos recopilados entre diciembre de 2024 y febrero de 2025. Según el análisis, el jugador medio del NYT Connections resuelve el 71 % de los puzzles, mientras que los mejores modelos LLM ya superan esa marca con claridad. Solo el modelo DeepSeek R1, con un 49,8 %, se encuentra cerca del desempeño promedio humano.

Los jugadores más hábiles, sin embargo, aún representan un reto para la inteligencia artificial: el usuario humano de referencia alcanzó una tasa de acierto del 100 % durante el mismo periodo. En comparación, el modelo o1 logró un 98,9 %, quedando muy cerca del nivel considerado «superhumano».

Un benchmark de referencia para el futuro del razonamiento LLM

El benchmark nyt-connections, mantenido activamente por Mazur, ha sido actualizado regularmente con nuevos modelos, puzzles y versiones optimizadas. Desde su publicación inicial en 2024, se ha convertido en una herramienta clave para evaluar la capacidad de razonamiento lógico, agrupación semántica y comprensión contextual de los LLM.

Además, se han añadido pruebas específicas como un subconjunto de los 100 puzzles más recientes para reducir el riesgo de que las soluciones estuvieran presentes en los datos de entrenamiento de los modelos.

Grok toma ventaja frente a OpenAI y Google

El éxito de Grok 4 en esta prueba supone un importante impulso para xAI en su carrera por competir con gigantes como OpenAI, Google DeepMind o Anthropic. Mientras modelos como GPT-4o, Claude Sonnet o Gemini siguen siendo populares por su versatilidad general, el liderazgo de Grok en tareas complejas de razonamiento evidencia su orientación específica a la resolución de problemas lógicos.

Sobre el proyecto

El repositorio público lechmazur/nyt-connections, alojado en GitHub, ha recibido más de 120 estrellas y continúa actualizándose con benchmarks adicionales para evaluar aspectos como creatividad, veracidad, engaño o generalización temática. El trabajo no está afiliado oficialmente con el New York Times, pero se apoya en su mecánica de juego para construir una evaluación rigurosa del rendimiento de los modelos.

Con la inteligencia artificial generativa en rápida evolución, benchmarks como este se perfilan como un estándar técnico imprescindible para evaluar las verdaderas capacidades cognitivas de los modelos y detectar sus límites. Y por ahora, Grok 4 parece haber dado un paso al frente.