La inteligencia artificial avanza a un ritmo imparable, con modelos generativos como ChatGPT y DALL-E que revolucionan la forma en que las personas interactúan, crean y consumen contenido. Sin embargo, esta innovación tecnológica ha suscitado preocupaciones éticas y legales, especialmente respecto al uso de datos protegidos por derechos de autor. En respuesta a estas preocupaciones, OpenAI ha anunciado Media Manager, una herramienta pionera que se lanzará en 2025 con la misión de ofrecer a los creadores de contenido un mayor control sobre el uso de sus obras en la formación de modelos de inteligencia artificial. Esta nueva solución promete revolucionar la forma en que los creadores, reguladores y las empresas de IA gestionan el uso de datos en este entorno digital.

Media Manager: Empoderando a los Creadores de Contenido

Media Manager es el intento más reciente de OpenAI para dotar de poder a los creadores de contenido, permitiéndoles especificar si su trabajo puede ser incluido o no en el entrenamiento de modelos de inteligencia artificial. Esto se logra mediante una plataforma que incorpora herramientas para identificar automáticamente si el contenido tiene derechos de autor. La herramienta también les permite a los creadores señalar sus preferencias en cuanto a la inclusión de su trabajo en el desarrollo de modelos como ChatGPT.

El objetivo principal es ofrecer un mecanismo de control preciso para evitar futuros conflictos legales relacionados con la propiedad intelectual. La herramienta emplea técnicas de aprendizaje automático para identificar varios tipos de contenido, desde texto hasta imágenes, audio y video, permitiendo que OpenAI trabaje en estrecha colaboración con los creadores para implementar políticas claras de uso.

Un Cambio Necesario en la Industria de la IA

El desarrollo de Media Manager no solo es una respuesta a los litigios en curso y a las preocupaciones expresadas por los creadores, sino también a las críticas crecientes sobre el proceso de formación de modelos de IA, que a menudo implica la recopilación masiva de datos en línea. Muchas veces, este proceso incorpora información protegida por derechos de autor sin el consentimiento de sus autores.

El enfoque tradicional ha sido controversial, ya que la formación de estos modelos requiere vastos conjuntos de datos que se recopilan de la web, abarcando contenido protegido y no protegido. Esto ha llevado a demandas contra OpenAI y otras empresas por parte de creadores que consideran que sus derechos han sido violados. Media Manager busca cambiar este paradigma al ofrecer a los creadores la posibilidad de elegir cómo y si quieren que su trabajo sea utilizado.

Colaborando para Establecer Estándares Claros

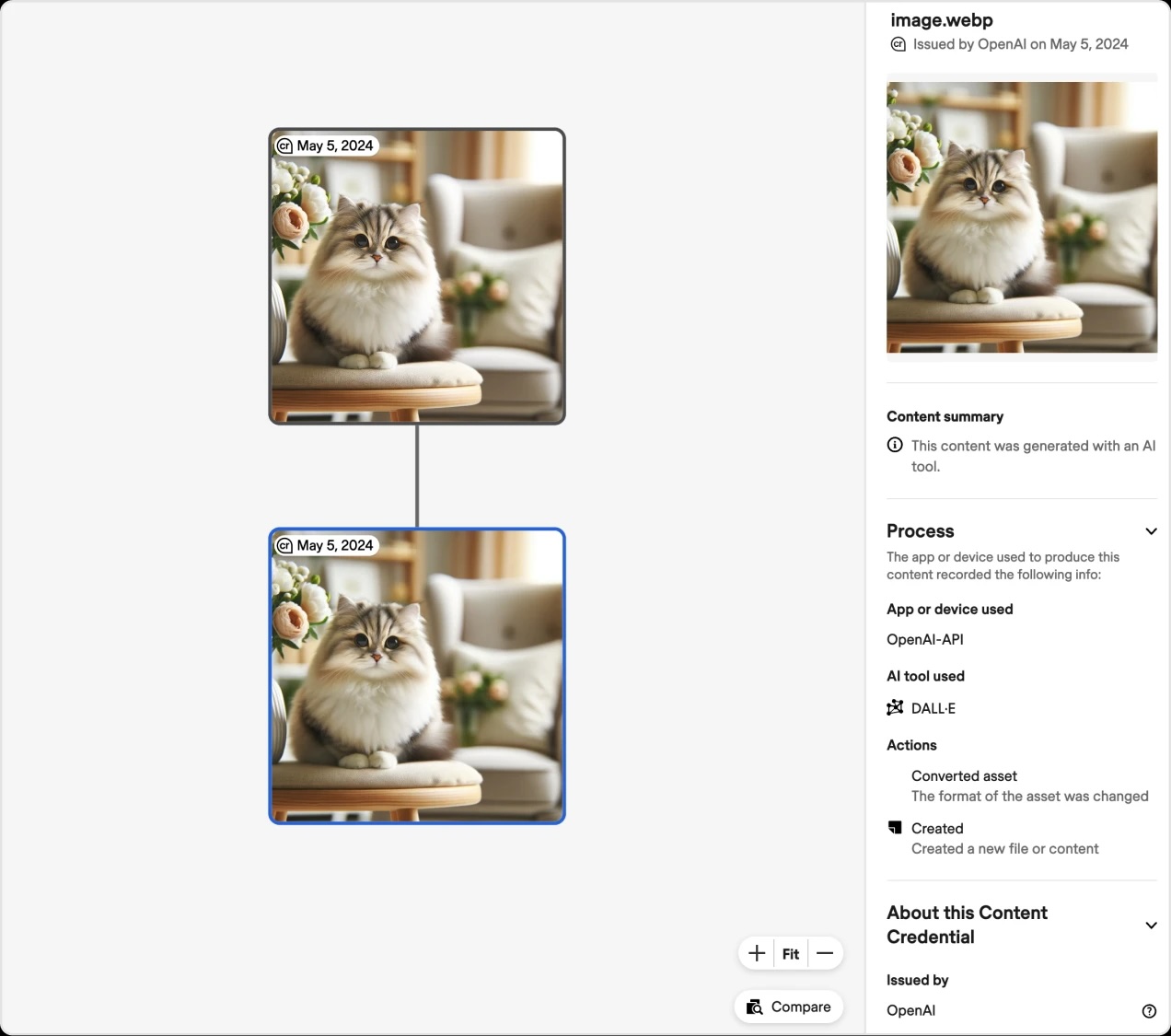

OpenAI no está trabajando solo en este esfuerzo. La empresa se ha unido a la Coalición para la Procedencia y Autenticidad de Contenidos (C2PA), una organización que establece estándares para la certificación del contenido digital. Al sumarse al Comité Directivo de C2PA, OpenAI busca contribuir al desarrollo de normas claras que ofrezcan transparencia sobre la procedencia de contenido generado o modificado mediante herramientas como DALL-E.

La colaboración con C2PA también refuerza la importancia de un enfoque colaborativo en la industria de la IA. Crear un estándar común facilita la tarea de verificar la autenticidad del contenido digital y permite que los usuarios comprendan cómo se ha producido la información que encuentran en línea.

Implementando Nuevas Herramientas de Detección

Además de Media Manager, OpenAI está implementando nuevas herramientas para detectar y autenticar contenido generado por IA. Por ejemplo, la empresa ha integrado marcas de agua avanzadas en las imágenes creadas mediante DALL-E 3, que se pueden identificar fácilmente como producidas por esta herramienta.

La marca de agua es tamper-resistant (resistente a alteraciones), lo que significa que es difícil de eliminar o modificar. Además, la empresa ha desarrollado un sistema de clasificación que permite identificar con un 98% de precisión si una imagen fue generada por DALL-E 3, comparando las imágenes producidas por este modelo con las no generadas por IA. Esta tecnología ya está disponible para los primeros investigadores a través del Programa de Acceso para Investigadores.

Facilitando la Colaboración en la Detección de Contenido Falso

OpenAI también ha lanzado un fondo de resiliencia social junto con Microsoft, valorado en 2 millones de dólares, para promover la educación sobre inteligencia artificial y facilitar la adopción de estándares como los desarrollados por C2PA. El fondo trabajará con organizaciones como Older Adults Technology Services, International IDEA y Partnership on AI para ayudar a las personas a comprender mejor el contenido generado por IA y cómo identificarlo.

Progresando hacia una Industria Ética y Transparente

Estos avances marcan un cambio significativo en el enfoque de OpenAI hacia la protección de los creadores y el uso transparente de contenido. Al ofrecer un mayor control y herramientas avanzadas de detección, la empresa se esfuerza por asegurar que el contenido generado por IA sea más fácilmente identificable y auténtico.

Sin embargo, el desafío va más allá de la tecnología. Para que estas herramientas sean realmente efectivas, será necesario un esfuerzo conjunto entre plataformas, creadores de contenido y consumidores para que la información sobre la autenticidad del contenido se mantenga a lo largo de todo su ciclo de vida. OpenAI reconoce esta necesidad de cooperación y la importancia de promover la comprensión y el uso responsable de la IA.

En última instancia, Media Manager representa el compromiso de OpenAI para empoderar a los creadores y combatir la desinformación en el panorama digital. La herramienta, que se lanzará en 2025, proporcionará un grado sin precedentes de control para los creadores, permitiéndoles decidir cómo se usa su contenido en la formación de modelos de inteligencia artificial. Esto no solo protegerá sus derechos, sino que también contribuirá a establecer normas claras y justas para la industria.

Con el respaldo de herramientas de detección mejoradas, marcas de agua avanzadas y la colaboración con C2PA, OpenAI está sentando las bases para una nueva era de transparencia y autenticidad en el contenido generado por IA. Este es un esfuerzo pionero que espera ser adoptado ampliamente por otros actores de la industria para crear un entorno digital más ético, auténtico y confiable para todos.